About me

藤田 和之 / Kazuyuki FUJITA

東北大学 電気通信研究所 准教授

Associate Prof., Research Institute of Electrical Communication, Tohoku University

Google Scholar / researchmap / Twitter

Contact: k-fujita [at] riec.tohoku.ac.jp

Short bio:

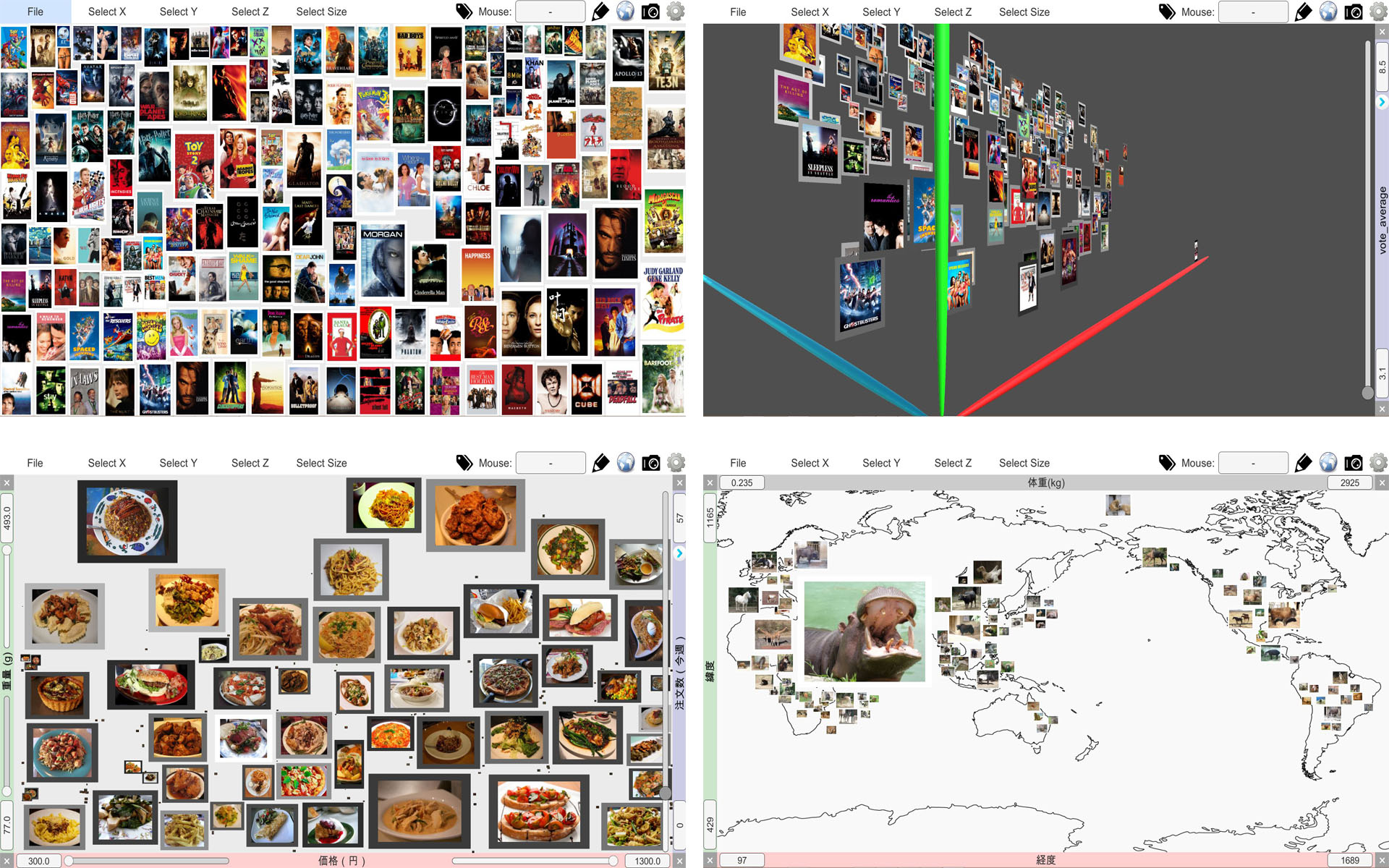

2010年 大阪大学 大学院情報科学研究科 マルチメディア工学専攻 博士前期課程 修了.2013年 同研究科 情報システム工学専攻博士 後期課程修了.同年 株式会社イトーキ.2018年より東北大学 電気通信研究所 助教(2023年より東北大学プロミネントリサーチフェロー).2024年より同准教授.博士 (情報科学).ヒューマンコンピュータインタラクションおよびバーチャルリアリティに関する研究,具体的には,人の活動を取り巻く「ワークスペース」に着目し,空間全体またはその構成要素とのインタラクションを通して人のさまざまな活動を支援する「ヒューマン・ワークスペース・インタラクション」の研究に取り組んでいます.

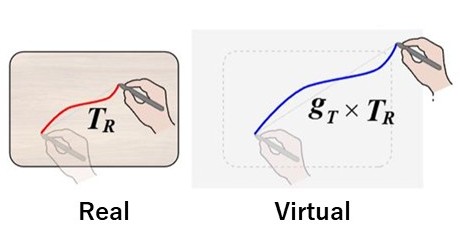

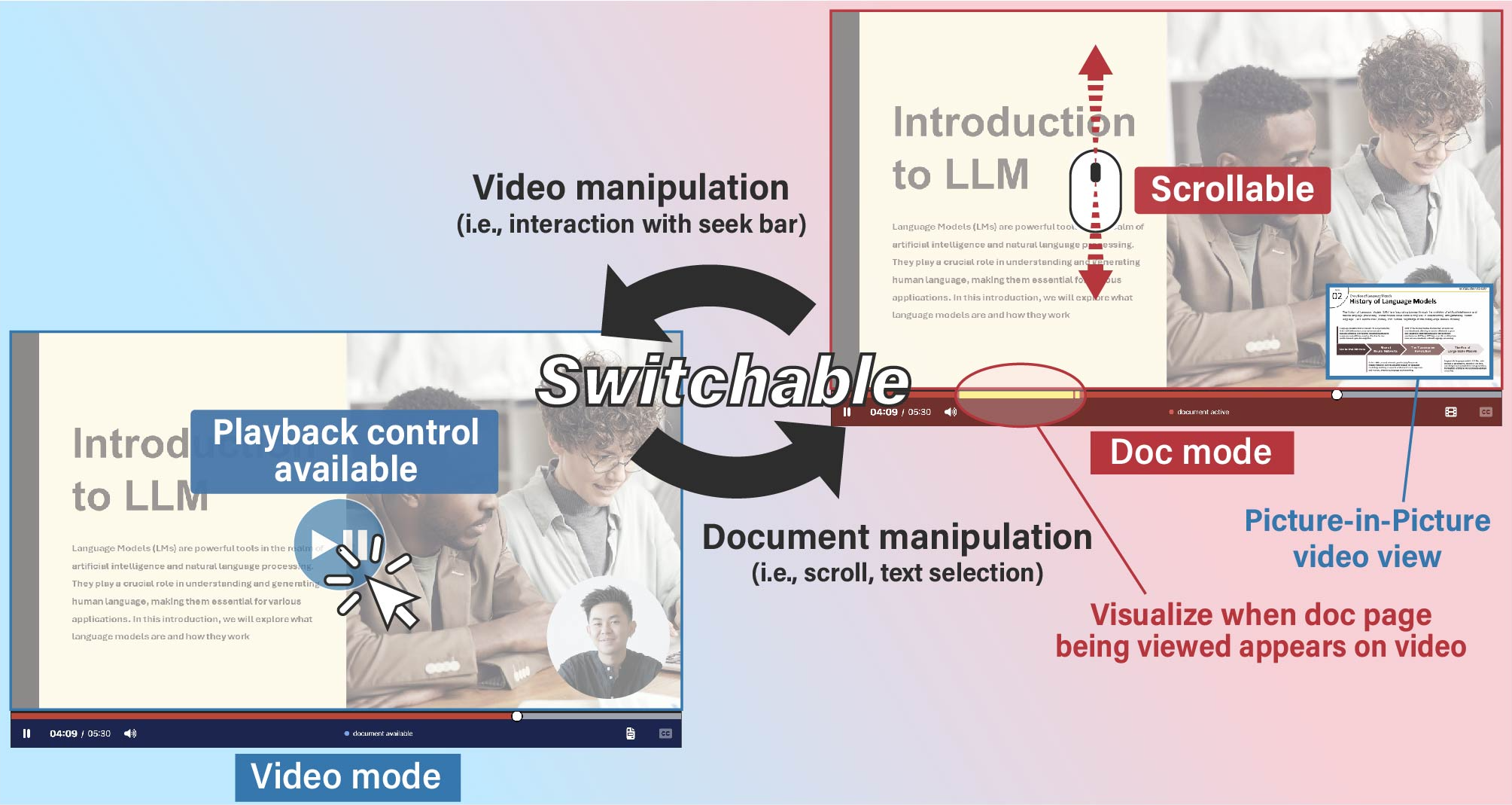

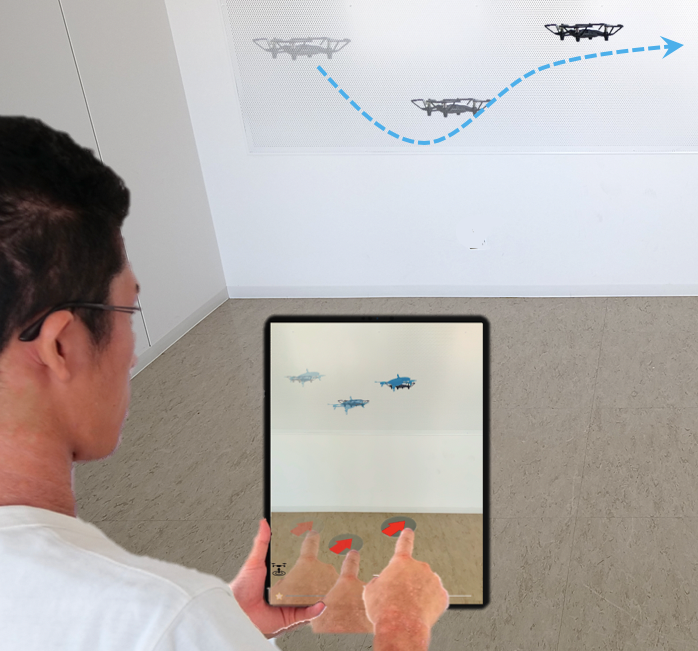

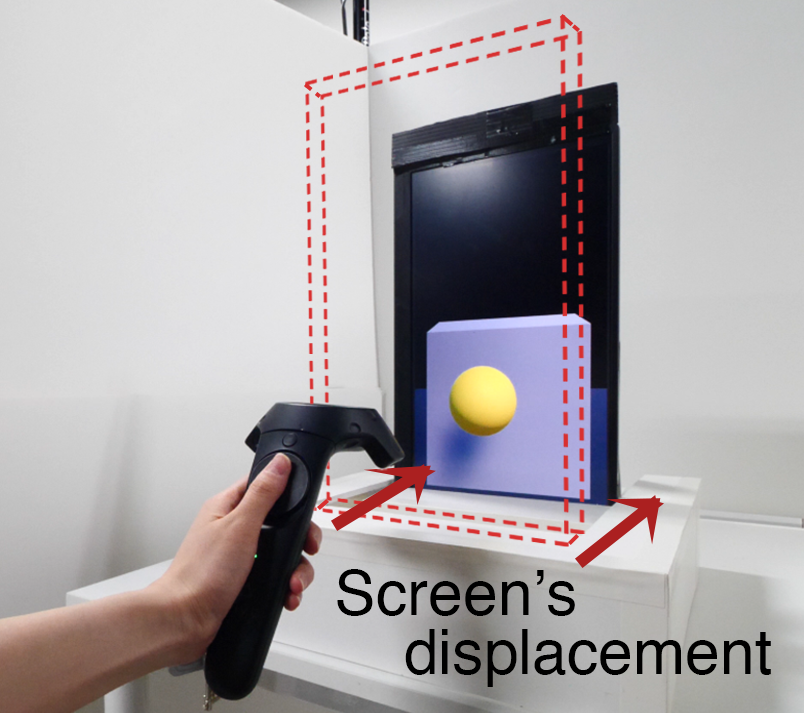

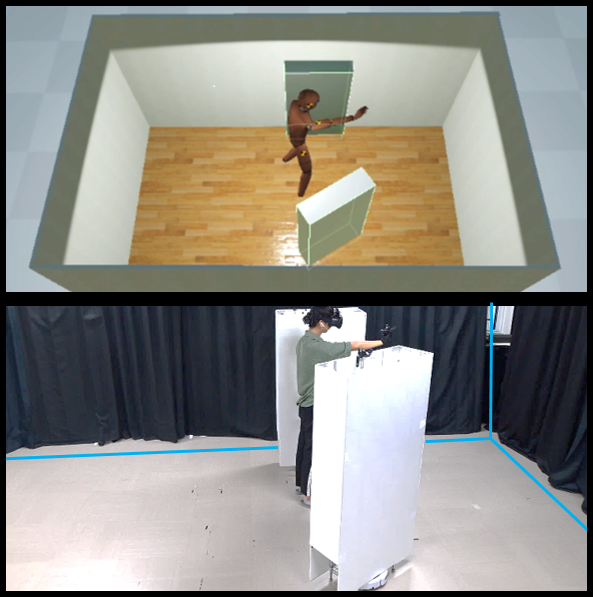

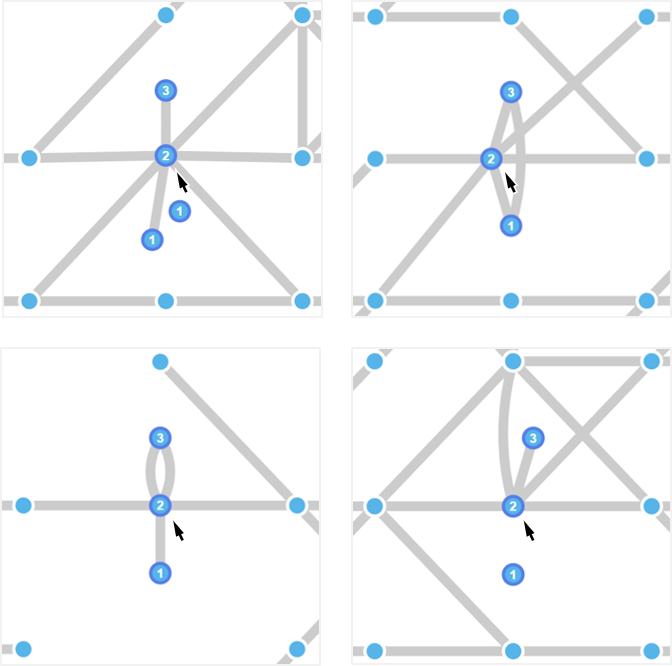

I, Kazuyuki FUJITA, am an Associate Professor of Research Institute of Electrical Communication (RIEC) at Tohoku University. I received my Ph.D. in Information Science and Technology from Osaka University in 2013. I worked for ITOKI, an office space design company, and was engaged in research and development on future offices for 2013-2018. From 2018 to the present, I have been working at RIEC, Tohoku University (as Assistant Professor in 2018-2024 and as Associate Professor from 2024). I have also been granted the title of Prominent Research Fellow at Tohoku University from 2023. My research interests include human-computer interaction and virtual reality. More specifically, I focus on "workspaces" that surrounds human activities, and research Human-Workspace Interaction, which supports various human activities through interaction with the computerized or virtualized workspaces and their components.